AI기술과 저널리즘을 선도해온 구글은 2일(현지시간) 미국 뉴욕 구글오피스에서 AI 연례 컨퍼런스 ‘AI@:불가능을 탐험하다’를 개최했다.

국내 주요 언론사의 보도가 여럿 나와 있지만 구글이 공개한 컨퍼런스 영상 전체 내용을 번역, 재구성했다. 콘텐츠 생산, 배포를 비롯 저널리즘의 가치를 높이는 데 AI를 주목하는 언론사들이 많다. 구글의 방향성과 기술들은 적지 않은 의미가 있을 것이다.

위대한 AI의 여정, 이제 시작이다

24년 전 구글은 거대한 목표로 시작했다. 그 미션은 세상의 정보들을 조직화 해 세계 어디서든 사람들이 접근할 수 있고 유용하게 활용할 수 있도록 하는 것이다.

인공지능(AI)은 구글이 목표를 이루는 데 중요한 수단이다. 2001년 구글은 검색시 더 나은 맞춤법 제안을 위해 간단한 머신러닝 기법을 활용했다. 10년 뒤인 2011년 딥 러닝으로 더 나은 음성인식과 더 정확한 지도제작 등 여러 분야의 길을 개척했다.

현재 AI는 (이미지) 검색, 번역, 다양한 피부색을 반영하는 카메라 등 사람들이 매일 사용하는 대부분의 제품에 적용됐다. 구글 클라우드는 뛰어난 AI 성능을 탑재해 여러 기관의 비즈니스에 기여하고 있다. 재난대응, 헬스케어, 교육 등 AI가 제공하는 다양한 범위와 역할에 주목하고 있다. 구글은 이 많은 기회를 포착하고 사람들을 돕는 방향에서 기여하려고 한다.

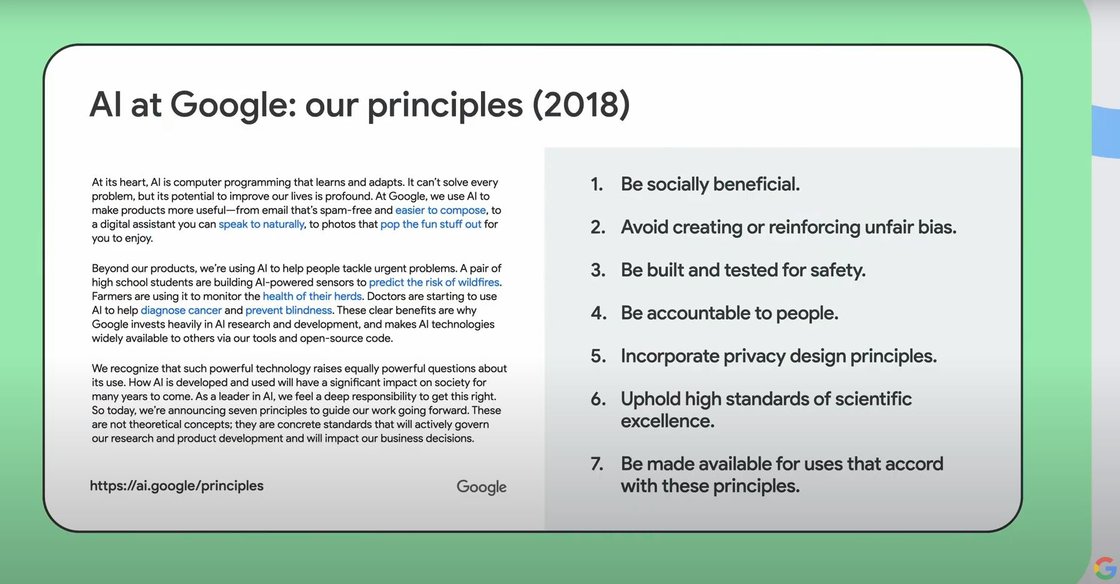

그런데 대다수 혁신 기술처럼 AI는 상당한 책임을 요구받는다. 구글이 시작부터 책임성 있는 AI(responsible AI)에 집중하는 이유다. 사람들의 안전과 정보보호에 초점을 둔 AI백서(principle)를 출판한 것도 같은 맥락이다.

이제 구글의 방향성을 담은 초기 연구들을 바탕으로 진척 상황을 공유한다. AI는 엄청난 기술이지만 아직 우리는 초기 단계에 있다. 향후 수년간 AI가 만들어내는 기회가 모두에게 돌아가도록 여러 전문가 및 파트너들과 협력하길 기대한다.

순다르 피차이 구글 CEO(최고경영자)

산모 초음파까지 사회복지 향한다

구글은 지난 10년간 AI 영역에 많은 진보를 일궜다. 이제 컴퓨터는 주변의 세상을 보고 듣고 이해할 수 있는 수준에 이르렀다. AI는 구글의 목표 달성에도 굉장히 중요한 역할을 차지한다.

내가 이끄는 ‘구글 리서치’ 팀은 구글의 미션을 위해 여러 근본적인 문제들을 해결하고 있다. 최근엔 인공지능에 집중하고 있다. 우리는 구글이 기술만이 아니라 전 세계 사람들에게 도움을 줄 수 있도록 책임성 있는 AI를 선도하고 있다는 데 자부심을 갖는다. 구글 클라우드를 기반으로 AI 적용은 우리 제품만이 아니라 다른 기업이나 과학 분야에 문제 해결을 돕고 있다.

기후변화 적응 등 사회복지(social good)를 위한 AI, 콘텐츠 생산 등 창의성(Creativity)에 기여하는 AI, 다양한 언어를 사용하는 사람들의 정보 접근을 돕는 언어 포용성(Language Inclusivity) AI가 대표적이다. 우리는 AI가 직면한 여러 문제와 위험들에 대해서도 논의할 예정이다.

또 구글의 AI 백서(2018)는 구글의 기술로 개인을 돕고 사회 전반에 혜택을 줄 수 있도록 어떻게 구글의 작업을 이끌어 나가야 할지 살펴보고 있다. AI를 바르게 사용하는 것이 협력적인(collective) 노력이어야 하는지도 검토한다. 여기에는 연구자를 포함해 각 분야 전문가, 커뮤니티 멤버, 비즈니스, 정부, 시민들을 포함한다.

내가 학생일 때 신경망 연구는 컴퓨팅 파워가 부족해 장난감 수준의 문제 해결만 가능했다. 하지만 지금은 신경망 아키텍처, 머신러닝 알고리즘, 머신러닝 하드웨어의 발전으로 실생활에서 부딪히는 문제들의 해결법을 찾을 수 있다.

제프 딘(Jeff Dean) 구글 부사장 겸 시니어 펠로우, AI 연구 총괄

사람들을 구하는 홍수 예측, 18개국으로 확대

기술이 세상에 미칠 수 있는 긍정적 영향은 많다. 헬스케어, 교육, 환경과 야생 등 여러 분야에서 활동하는 커뮤니티를 지키는 케냐의 '레와(Lewa)' 지역을 꼽을 수 있다. 구글 리서치는 AI기술을 활용해 여러 지역 사회가 처한 문제를 해결하는 데 노력하고 있다.

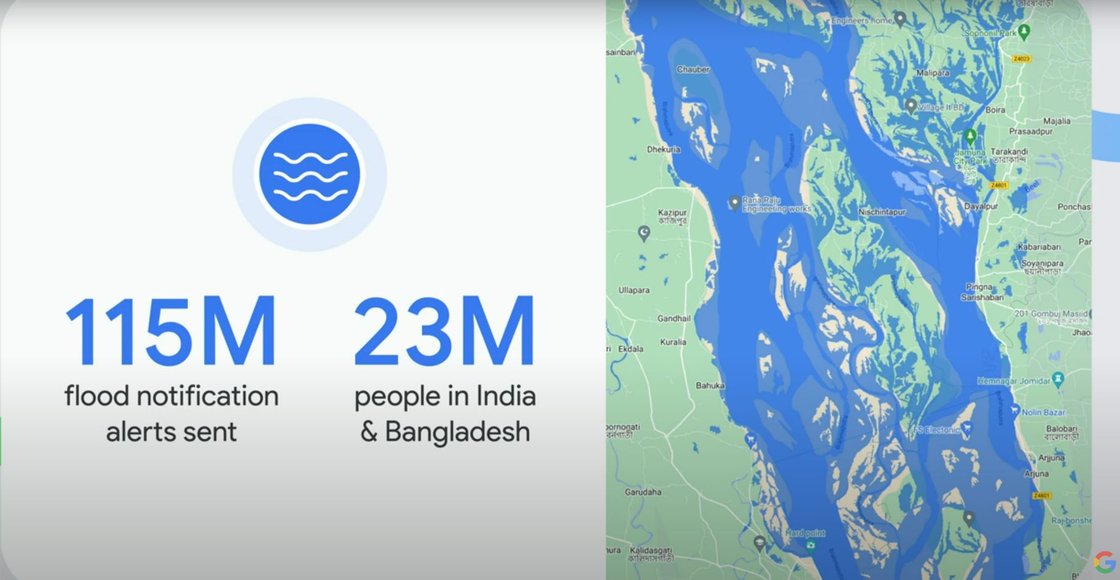

이런 노력 가운데 한 가지는 홍수 예측 및 경보 이니셔티브의 확장이다. 홍수는 매년 수천 명의 목숨과 수백만 달러의 재산 피해를 야기한다. 특히 홍수는 자원이 부족한 지역의 개인들에게 그 영향을 미친다. 이들은 보통 홍수 예측 및 경보 시스템을 제공받지 못하고 있다. 선제적이고 정확한 홍수 경보는 인명 및 경제적 피해를 30~50%까지 줄일 수 있을 것으로 예상한다.

2021년 우리는 구글 검색과 지도를 통해 2300만명에 달하는 인도 및 방글라데시 지역 주민들에게 1억 1500만 개의 홍수 알림 경보를 제공했다. 예일 경제성장 연구센터의 초기 연구에 따르면 구글 어플리케이션이 경보를 받는 사람의 수를 3배, 보호 대책이 취해진 사람의 수를 4배 가량 늘렸다. 구글은 이 홍수 경보 이니셔티브를 브라질, 콜롬비아, 스리랑카, 나이지리아, 콩고 등 18개국으로 확장한다.

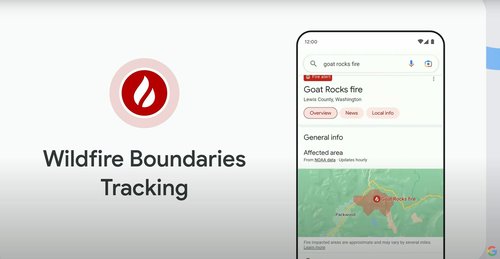

구글 리서치는 최근 10년간 증가하고 악화할 것으로 예상하는 산불(wildfire)에도 주목하고 있다. 매년 산불은 수십억 달러의 피해와 7기가 톤의 이산화탄소를 배출하고 있다. 위성 사진을 기반으로 학습한 구글 머신러닝 모델은 실시간으로 산불을 포착 및 추적하고 확산을 예측한다. 이는 소방관을 비롯한 여러 초기 대응자들의 대응을 돕는다. 우리는 현재 산불 예측 및 대응 시스템을 캐나다, 미국, 멕시코, 호주에서 적용하고 있다.

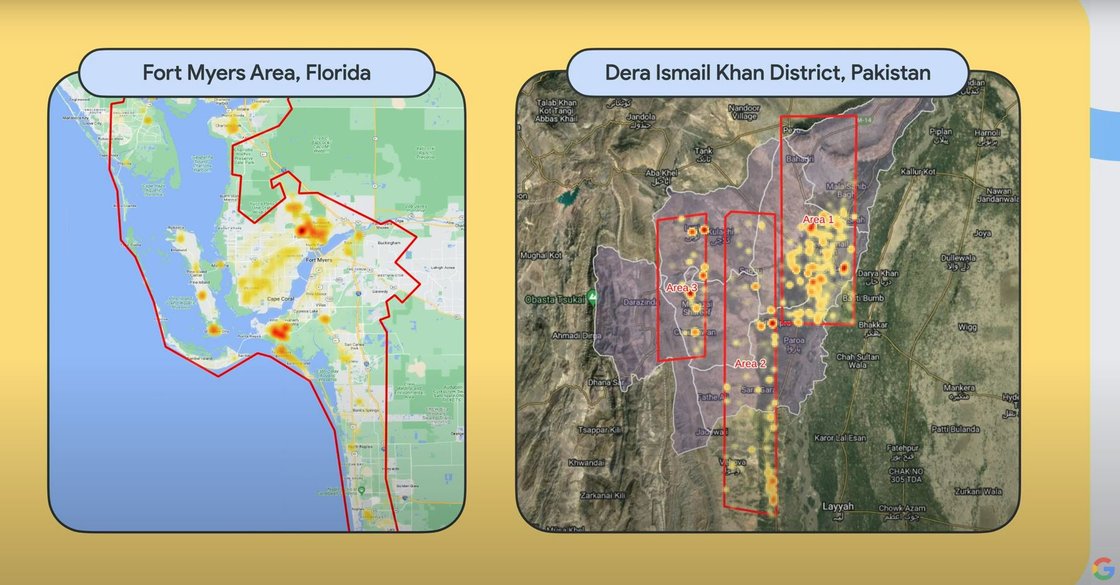

구글 리서치는 재난 예측 및 추적을 넘어 사후 재난 구제에도 활용하고 있다. UN 세계식량계획(UN World Food Programme)과 협력하여 위성 사진을 분석, 재난 후 파손된 건물들을 파악할 수 있는 머신러닝 도구를 개발했다. 재난 후 피해 정보를 제공함으로써 초기단계에서부터 가장 피해가 극심한 지역을 파악할 수 있도록 돕는다.

지난번 허리케인 이안(Ian)이 불어닥쳤을 때, 우리는 이 기술을 활용해 40만여 개 이상의 건축물들을 분석, 6만 9000개의 파손 건물들을 식별했다. 이 정보를 통해 피해 발생 일주일 내로 구호 단체가 극심한 피해를 입은 2900여 개의 저소득 가구에 2백만 달러를 정확히 전달할 수 있도록 도왔다.

같은 기술을 최근 파키스탄에서 발생한 홍수와 관련 정부 재난지원 대책에도 적용시켰다. 이처럼 관련 조직과 기관에 기술을 제공해 가장 필요로 하는 사람들에게 지원이 이뤄질 수 있도록 그 적용 지역을 확대할 예정이다.

더불어 의료 영역에도 AI를 적용해 헬스케어에 제약이 있는 사람들에게 중요한 의약 정보를 제공할 계획이다. 하나의 연구 프로젝트는 초음파 전문가가 부족한 지역의 산모 생존률을 늘리기 위한 초음파 AI이다. 노스웨스턴 의약(Northwestern Medicine)과 파트너십을 맺고 간호사와 조산사들이 초음파 사진을 쉽게 수집하고 해석할 수 있도록 도왔다.

구글의 초음파 AI 도구는 태아의 위치 등을 파악해 임신 초기 의료 인력들이 문제점을 포착하는데 중요한 역할을 한다. 무엇보다 인프라가 부족한 지역에서도 사용될 수 있도록 연결 장치가 없는 저가 장비에서도 활용이 가능할 수 있도록 설계했다.

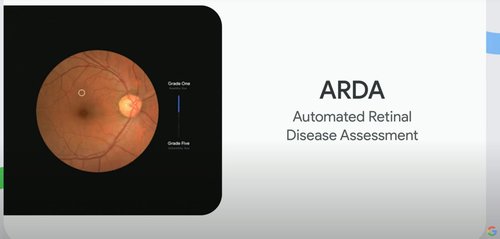

또한 소비자가 휴대폰에서 사용할 수 있는 헬스케어 앱들을 고도화 하고 있다. 가장 장기간 투자한 것 중 하나는 자동화 망막 질환 평가(ARDA, Automated Retinal Disease Assessment) 솔루션이다.

앱을 통해 실명을 유발하는 가장 큰 원인 가운데 하나인 당뇨병성 망막증(diabetic retinopathy)을 예방할 수 있다. 공공 의료기관들과 협력해 15만 명 이상의 환자들에게 ARDA 검사를 제공했다. 작년에만 우리는 이 검사 수를 두배로 늘렸다. 기술을 진보시켜 소비자 스마트폰으로 촬영하는 사진 만으로도 눈 질환 검사를 가능케 할 계획이다.

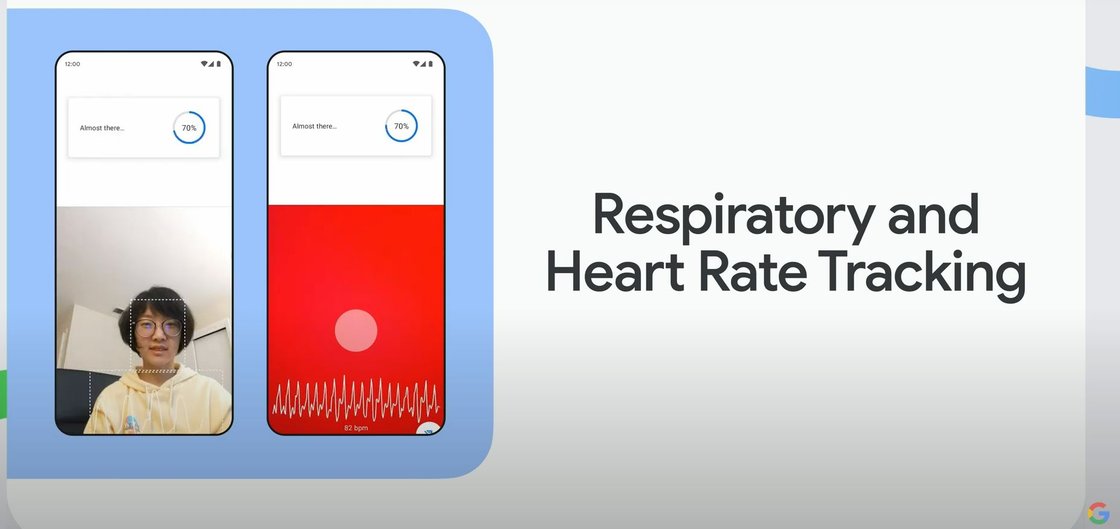

한편 컴퓨터 비전(vision)의 발전은 스마트폰을 호흡기와 심장 박동 추적 등 강력한 환자분류 관리(triaging care) 도구로 탈바꿈시키고 있다. 이 기술은 현재 수천 명의 환자들에게 도움을 주고 있다.

지난 달에는 기침과 코골이 같은 수면 방해 요인을 측정할 수 있도록 그 기능을 확장했다. 이는 처음으로 환자들이 자신의 호흡기 건강에 대한 정보를 손쉽게 접근할 수 있게 해준 사례이다. 하지만 헬스케어와 클리닉 과정을 손쉽게 구성하려면 아직 갈 길이 멀다.

캐서린 추(Katherine Chou) 구글 리서치 시니어 디렉터(Senior director of Google research)

콘텐츠 생산 넘어 인간에게 과정 제어 권한 부여

활자, 조판기계, 카메라 등은 인간 스스로를 표현하기 위해 사용됐다. 이를 확장해 정보를 조직화하고, 창의성을 촉진하고, 창의성을 보존하는데 기여할 예정이다. 새로운 걸 발견하고, 발명할 때 돕는 활동이다.

가장 적합한 기술은 생성모델이다. 생성모델은 창작물들을 생성하는 AI 영역으로 최근 가장 빠르게 진보했다. 텍스트, 코드, 소리, 이미지, 영상들을 만들어낼 수 있다.

생성모델은 단순히 사실적인 이미지를 만들어내는 게 아니라 텍스트 프롬프트 등 인간이 입력하는 요소를 갖고 창작해내는 것이다. 기술 진보로 이제 인간은 이제 콘텐츠 생산 과정을 제어(control)할 수 있다.

기술(기계)과 인간의 창작은 항상 교류가 존재했다. 생성모델은 전자음만 만들어내는 전자기타와 달리 원재료들을 구성, 편집, 생성하도록 도와 인간을 창작 과정에 더 깊게 파고들 수 있도록 돕는다. 바로 콘텐츠 생산자인 인간의 제어권을 의미한다.

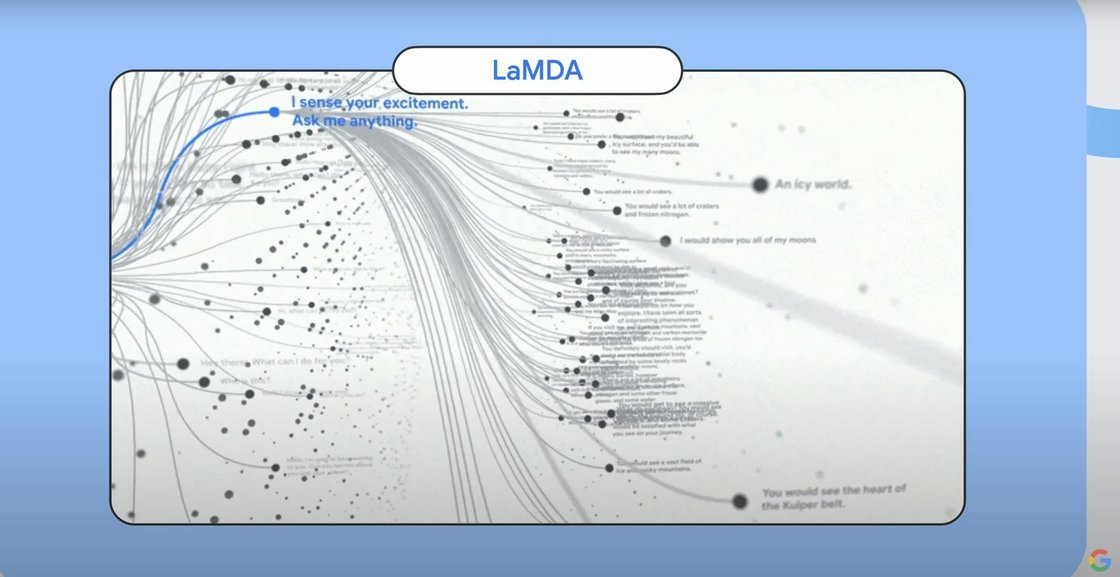

람다(LaMDA)는 다양한 주제에 이용자를 참여시킬 수 있는 대화(dialog) 엔진이다. "이 대화엔진으로 인간의 글쓰기를 보조하고 작가의 스토리텔링을 돕고 더 나아가 글길이 막히는 것(writer’s block)에 돌파구를 제공할 수 있을까?"

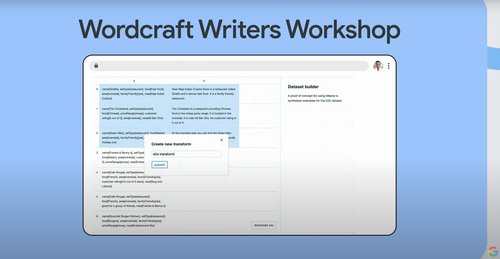

이 과제를 갖고 작가들이 직접 사용할 수 있는 도구(wordcraft writers workshop)를 만들었다. 숙련 작가들에게 람다를 도구로 소설을 작성케 했다. 이 작업물을 연구논문과 함께 발표할 예정이다. 한 가지 확실한 것은 람다를 이용해 완전한 소설을 작성하는 것은 불가능하다는 점이다.

하지만 작성된 소설에 재미(spice)를 더하는 것은 효과적이었다. 예를 들어 구체적인 캐릭터나 이야기의 한 측면을 강화할 때이다. 람다가 보조한 창작물들을 읽어보면 재밌을 것이다.

또 한 가지 깨달은 점은 이용자 환경(UI)이 적합해야 한다는 점이다. 워드크래프트 도구는 인간이 생성모델과 상호작용할 수 있도록 돕는다. 목적성이 뚜렷한 텍스트 에디터인 셈이다. 이러한 UI가 없으면 작가들은 생성모델을 이용해 작업할 수 없다.

AI를 활용하면 소프트웨어 개발을 도울 수 있는 코드 창작에도 유용하다. 이 분야는 텍스트 창작과 유사하다. 구글 코드 러닝(Learning for Code) 프로젝트는 언어 모델과 코드 저장소와 연동하여 코딩을 할 때 AI가 적합한 코드 제안을 만들어내도록 유도한다.

구글에서 개발자들에게 단일 코드라인과 장문의 코드라인에 대한 자동완성(completion) 기능을 제공해 내부적으로 테스트했다. 아직 실험 단계지만 코드 반복(iteration) 작업 시간의 효율을 6% 끌어올렸다.

구글은 최근 소리(audio) 학습모델(LM)을 공개했다. 이용자가 제공하는 작은 단위의 음악 샘플을 갖고 Hi-Fi(High-Fidelity, 원음과 원화에 충실한 재현)음악을 생성해낼 수 있다. 이는 버튼을 누르던 과거와 달리 음악 창작 과정에 더 많은 제어를 가능하게 해준다.

소리학습모델의 가장 흥미로운 점은 전문가의 손길이 없어도 된다는 점이다. 악보(musical score)도 전혀 필요 없다. 어떤 소리 클립이 주어지더라도 그것을 바탕으로 음악을 창작할 수 있다.

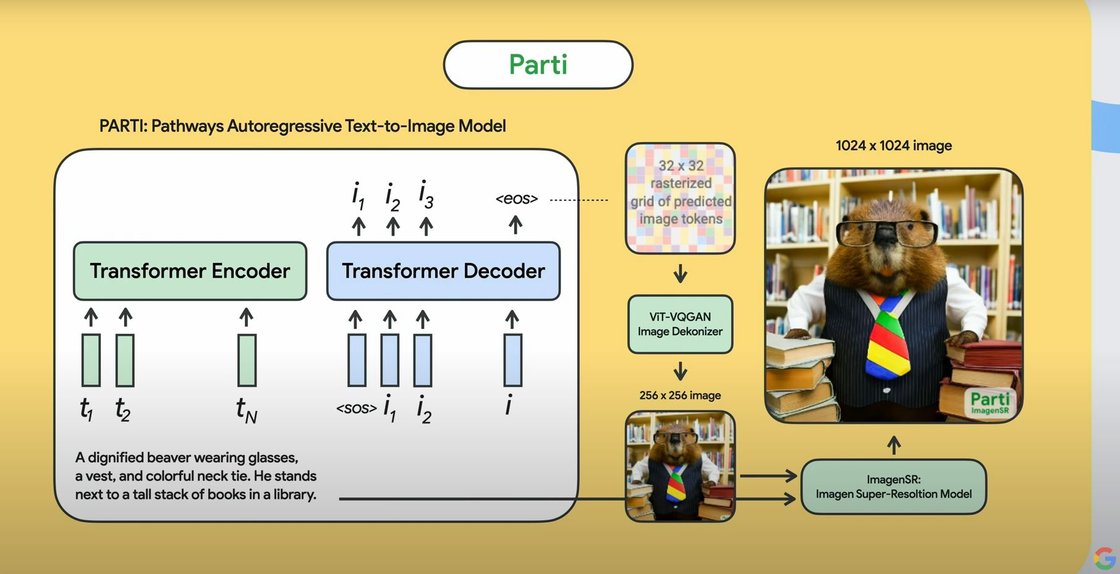

가장 인기 있는 텍스트 투 이미지(text to image) 모델은 여러 모델을 거쳐 이매진(Imagen)과 파티(Parti) 등 새로운 이미지 모델로 고도화되고 있다.

파티는 언어모델 즉, 텍스트에 집중해 텍스트 프롬프트를 정확히 구현하는 데 초점을 맞춘다.

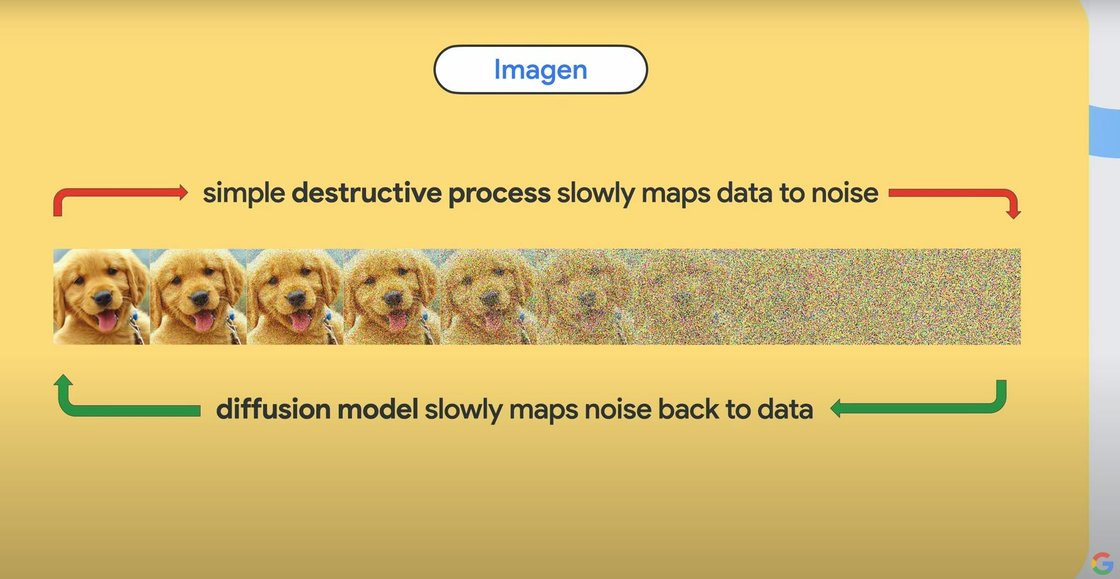

반면, 이매진은 이미지에 집중한 모델로 이미지를 흩뜨려 천천히 데이터를 노이즈로 매핑하거나 그 반대로 노이즈를 다시 이미지 데이터로 매핑하는 디퓨전(diffusion) 모델 등 두 가지 방식을 사용한다.

두 방식을 사용하는 이유는 아직까지 어떤 방식이 성공적으로 활용될 방식인지 알 수 없기 때문이다. 또 어떻게 하면 두 모델의 핵심기능을 창의적으로 활용할 수 있을지 고민하고 있다.

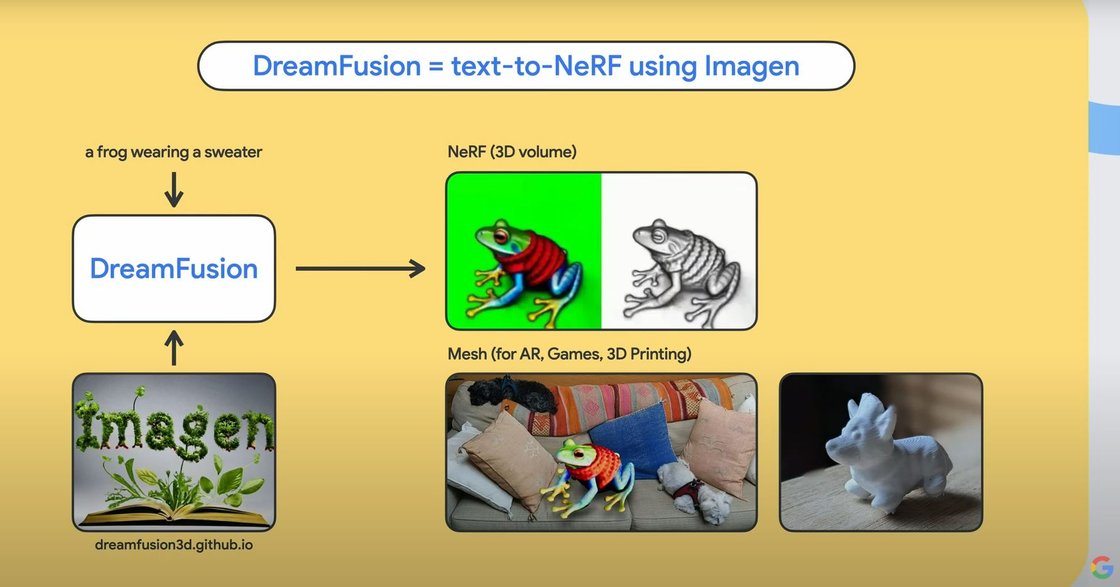

그 결과물이 드림부스(DreamBooth), 드림퓨전(DreamFusion) 프로젝트이다. 드림부스 프로젝트는 개인화된 촬영 부스의 개념이다. 이미지의 주제를 정하면 그 위에 어떤 세팅이든 적용할 수 있다. 예를 들어 강아지 이미지를 정하면 배경 및 행동 등을 적용해 새로운 사진 창작이 가능하다. 드림퓨전은 드림부스의 3D 모델링 버전으로 3D로 렌더링된 이미지 모델은 애니메이션이나 영상에도 활용이 가능하다.

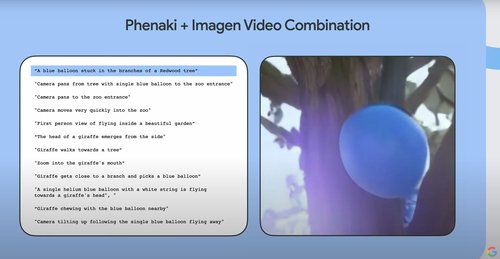

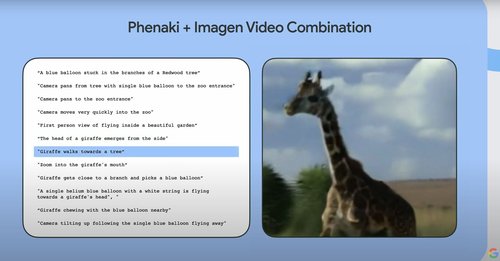

마지막으로 텍스트 투 비디오(text-to-video) 영역이 있다. 해상도가 높고 시간적으로 일관된 영상을 만드는 것은 매우 어려운 일이다. 프레임마다 이미지가 선명하고 매 시퀀스의 이미지가 이어져 하나의 스토리를 만들어내야 한다. 각 부분을 다루는 두 가지 프로젝트가 있는데 이매진 비디오(Imagen video)와 페나키(Phenaki)다.

이매진 비디오는 이매진에서 사용되는 디퓨전 방식을 사용해 선명한 영상을 구성한다. 페나키는 시간이 지남에 따라 토큰을 생성하는 언어모델을 활용해 일관성 있는 스토리가 담긴 긴 영상을 만들어 낸다.

정말 놀라운 일은 두 가지 프로젝트를 융합했을 때 일어난다. 이매진 비디오와 페나키를 합쳐 일관된 스토리를 갖춘 장편 영상을 높은 해상도로 만들어낼 수 있다. 실제 제작된 영상을 보면 구체적인 텍스트 설명의 시퀀스에 맞춰 고해상도로 구현된 영상이 구현돼 있다. 영화 제작자, 영상 제작자 그리고 일반인들까지 이 기술을 활용하는 때가 오리라 기대한다.

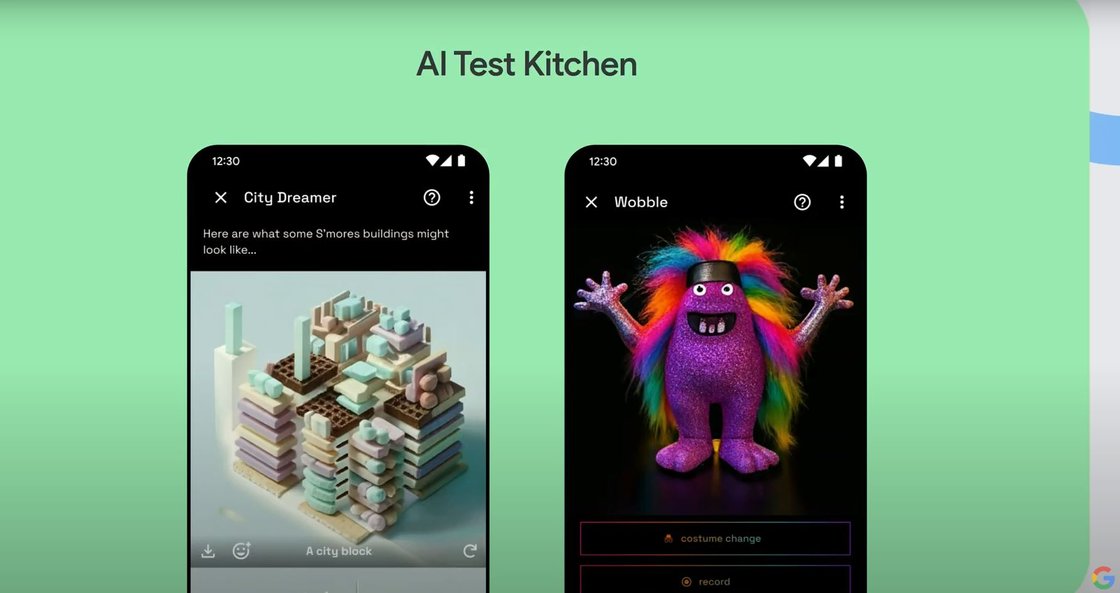

구글은 보유한 기술 몇 가지를 합쳐 모든 사람들이 경험할 수 있도록 지원할 계획이다. 올해 초 발표한 AI 테스트 키친(AI Test Kitchen) 앱은 구글이 개발 중인 AI기술을 배우고, 경험하고, 피드백을 제공할 수 있다.

곧 텍스트 투 비디오 기능을 추가하여 다양한 영상을 제작할 수 있도록 할 것이다. 이 앱은 지금 구글 플레이 스토어에서 다운로드할 수 있다.

AI의 책임성을 강화해야 할 때이다. AI가 인간에게 표현의 도구나 제작과정의 제어권처럼 혜택을 주지만 동시에 문제점도 갖고 있다. 구글이 AI기술을 배포하는데 시간을 두고 진행하는 이유도 여기에 있다.

특히 창의성을 발휘해야 하는 전문직들의 삶에 미치는 영향이 크다. 예를 들어 AI로 인한 허위조작정보나 가짜뉴스 확산으로 뉴스와 미디어에 대한 전반적인 불신이 발생할 수 있다. 그래서 조심스럽게 데이터셋과 이용자 경험을 만들어 가고 있다. 책임성 있는 행동의 일환으로 2018년 발표된 구글 AI 백서를 리서치 팀의 일에 적극적으로 반영하고 있다.

생성모델은 3가지 영역에 집중하고 있다. 제어와 안전(control & safety), 생성모델 식별 지원(Helping identify generative AI) 그리고 모두를 위한 개발(Building for everyone)이다.

앞에 두 영역은 제어에 관한 것이다. 미디어 제작 과정의 제어로 유해 혹은 폭력적인 미디어를 예방하는 것이 목표다. 동시에 최대한 창의성을 발휘할 수 있도록 UI, UX 등 모델 제작에 노력하고 있다.

또 제작된 미디어를 유통하는 과정에서 진실성(authenticy)을 식별 가능하도록 만들고 있다. 가령 소리 학습모델로 실제 스피치를 구분할 수 있는 분류기(classifier)를 만들었다. 정확도는 99%다.

구글은 AI기술로 미디어 제작을 책임감 있게 진행하고, 유통시 신뢰를 높이는데 주력하고 있다. 커뮤니티와 교류해 작가, 화가, 영상 제작자 등 여러 분야에서 일하는 사람들이 창작 활동에 필요한 것들을 파악하고 제공하는 노력을 기울이고 있다. 이같은 활동의 궁극적인 방향성은 AI 기반 창작에서 가장 중요한 것은 인간의 창의성이 전제이자 근간이 되어야 한다는 데 있다.

더글라스 에크(Douglas Eck) 구글 리서치 시니어 리서치 디렉터

다양성 위해 전 세계 1000개 언어를 품는다

구글 검색엔진에 도움을 준 연구 논문 그리고 구글의 노력을 잘 보여주는 언어 기반 AI모델

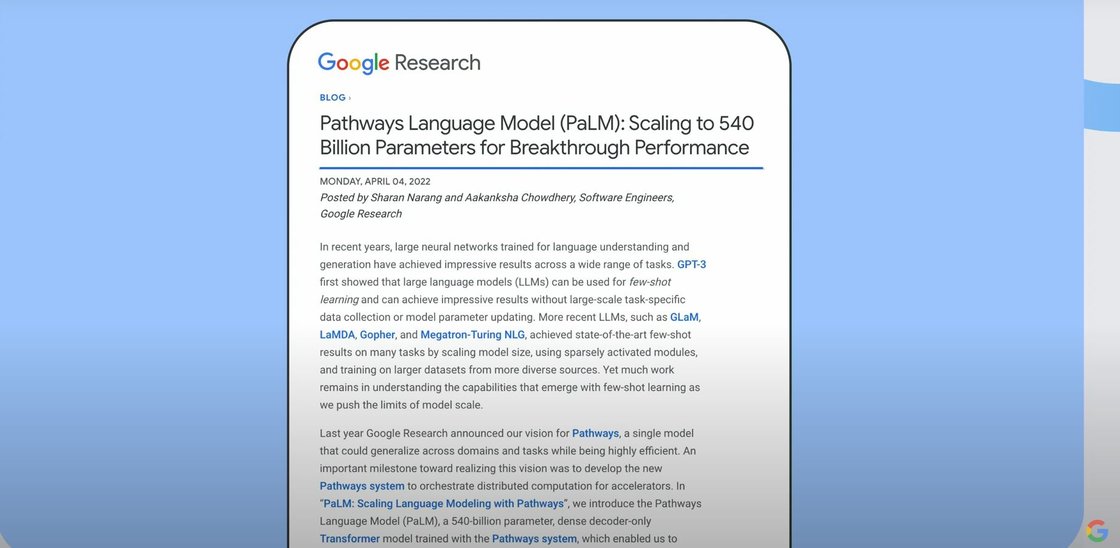

언어는 인간이 서로 커뮤니케이션하고 주변의 세상을 이해하는 핵심이다. 구글이 언어기반 AI에서 최고가 되려는 이유이다. 올해 초 구글 IO에서 발표한 유능한 모델인 PaLM은 AI 연구 및 발전에 기반이 됐다.

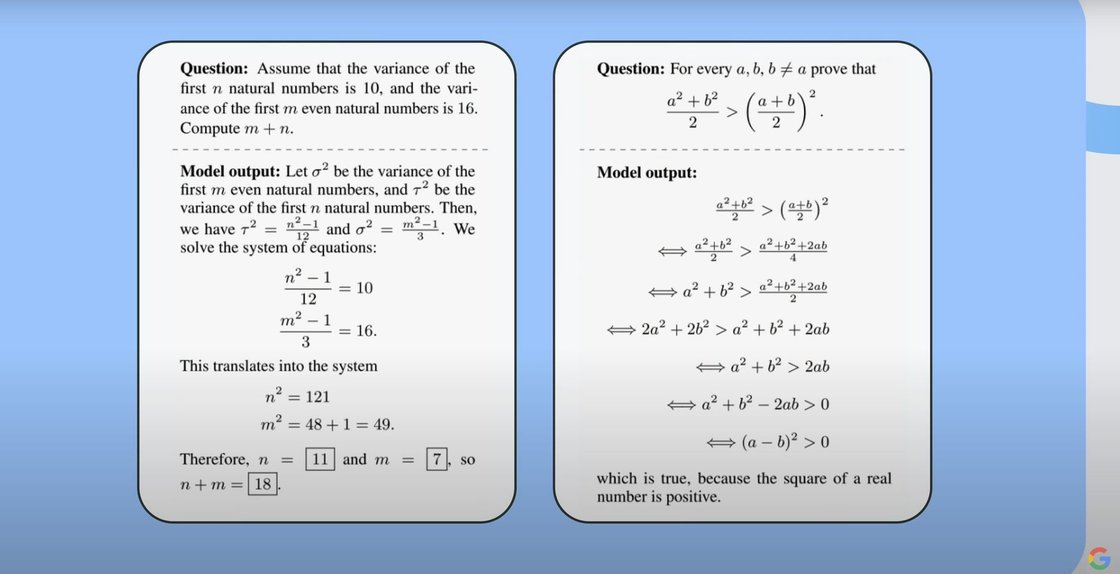

PaLM을 설계하고 과학 논문으로 학습한 AI 시스템 미네르바는 복잡한 수학문제를 풀어낼 수 있다. 학부졸업생 수준의 수학 연산이 가능하다. 이는 미네르바가 수많은 연구논문을 탐색 및 분석하여 패턴을 찾아내 궁극적으로 상징적, 산술적 추론을 학습했기에 가능하다.

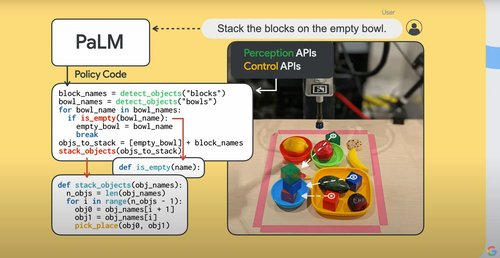

현재 PaLM으로 로봇을 더 진화시키고 있다. 지금의 대다수 로봇들은 산업 영역에 한정되어 구체적인 작업만을 수행한다. 로봇들이 더 일반적으로 이용되도록 PaLM의 자연어 이해 능력, 즉 PaLM에 코딩된 현실세계의 지식을 서비스 로봇을 대상으로 하는 학습모델에 적용했다.

세이캔(SayCan) 로봇 학습모델을 개발해 로봇들이 복잡하고 추상적인 작업을 가능하게 만들고 있다. 최근 로봇이 언어를 통해 보는 현실을 어떻게 이해할 수 있는지 그리고 이러한 이해를 기반으로 자신만의 코드를 실시간으로 작성할 수 있는지 연구를 확장하고 있다.

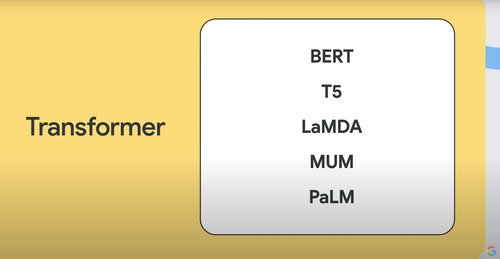

2017년 발표된 트랜스포머(Transformer) 모델은 구글의 AI 기술 발전과 기여도를 보여주는 단적인 예이다. 발표 당시만 해도 사람들은 이 모델이 지금까지의 대다수 첨단 언어모델의 기반이 될지 몰랐다. 방금 소개한 PaLM부터 생성모델의 LaMDA모델까지 다양한 모델이 트랜스포머 모델을 기반으로 만들었다. 이 모델들이 모든 사람들에게 혜택을 줄 수 있길 바란다.

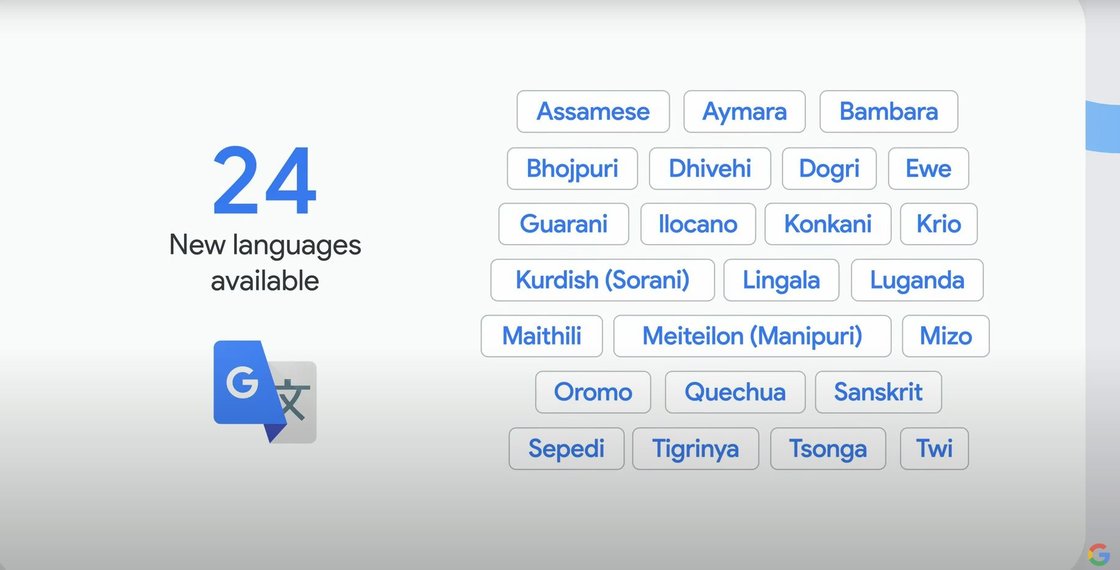

다음 언어모델의 기능과 영향을 생각하면 7000여 개가 넘는 전 세계 언어들의 다양성을 반영할 수 있는 것이 중요하다. 온라인에서 사용량이 적은 언어는 기술이 생각한 것처럼 작동하지 않는 경우가 많다. 구글은 번역모델에 다양성이 포함되도록 노력을 기울이고 있으며, 최근 24개의 새로운 언어를 추가해 133개 언어를 지원하고 있다.

하지만 아직 부족하다. 세계적으로 가장 많이 이용되는 1000개 언어를 지원하는 '1,000개 언어 이니셔티브(language initiative)' 구축에 나선다. 프로젝트 핵심은 다중양식(multimodality), 커뮤니티 그리고 제품이다.

초기 시장과 비교할 때 이용자가 구글을 통해 정보에 접근하는 방식은 변화했다. 텍스트부터 지금의 음성 스피치와 영상까지 다중양식 지원이 가능한 모델을 만들어 접근성을 높여야 한다. 400개가 넘는 언어를 지원하는 보편적 스피치 모델(Universal Speech Model)은 지금까지의 스피치모델 중 가장 많은 언어를 지원한다.

다음으로 더 넓은 범위의 커뮤니티를 지원한다. 구글은 아프리카의 연구자 및 기관과 협력해 관련 데이터를 만들어냈다. 남부 아시아에서도 우리는 현지 조직 및 기관과 협력해 현지 환경을 반영한 음성 데이터를 수집하는 등 언어를 실제 사용하는 현지 커뮤니티와 소통 및 협력해 언어모델을 만들고 있다. 구글은 더 다양한 연구 커뮤니티와도 협력할 계획이다. 곧 연구논문들을 발표해 이러한 연구 커뮤니티들이 새로운 프로젝트를 시작할 수 있도록 할 것이다.

마지막으로 구글 키보드인 지보드(gboard)나 번역기 등 구글의 제품에서 다양한 언어를 포함한 언어모델이 지원되도록 할 것이다. 다양한 언어 지원 AI를 위한 여정은 수년이 걸릴 여정이지만 모두에게 이로운 언어모델과 AI를 위해 필수적이다.

주빈 가라마니(Zoubin Ghahramani) 구글 리서치 VP

올바른 AI를 모색하는 공동체가 필요하다

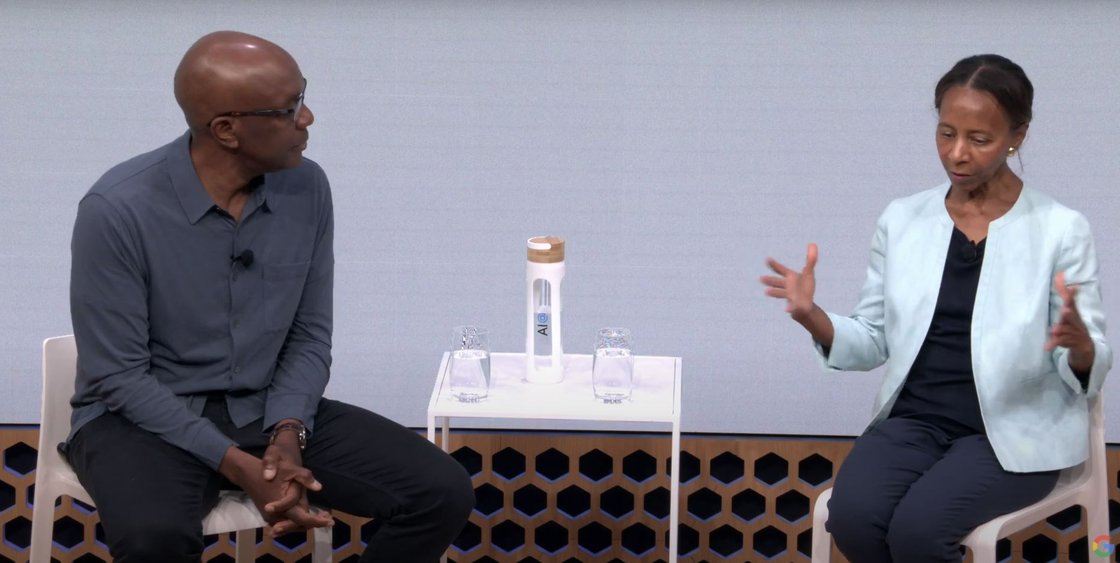

메리언: 구글에 가장 흥미로웠던 점은?

제임스: 돌파구를 만들어내는 혁신적인 연구 결과와 기술의 보편화가 빠르게 진행되고 있다는 점이다. 양자역학 등 과학 기술, 언어모델도 주목하고 있다. 또 기후과학과 여러 국가들로 기후예측 시스템이 확장되는 것을 보면 감탄이 나온다. 생성모델의 창작 기여도 마찬가지다.

메리언: 인간이 AI기술을 제어할 수 있도록 하는 부분이다. 단순히 AI 기술의 판단에 영향을 받는 것과 반대로 AI시스템과 협력적으로 일할 수 있게 하는 것이다. 동시에 AI시스템으로 어려움을 겪는 사람들을 지원할 수 있도록 돕는 포용성도 있다. 그러나 AI로 인한 부작용도 살펴봐야 한다. 개인적으로 주목하는 것은 무엇인지?

제임스: 동감이다. 구글에 합류하기 전 했던 작업도 기술이 발생시킬 수 있는 위험과 도전과제들을 고민하는 것이었다. 한 가지 측면은 AI기술이 우리가 의도한대로 작동하지 않을 경우 발생하는 편향이나 유해성이다. 다른 측면은 기술의 이용과 오용이다. 기술이 정상적으로 작동하더라도 개발자와 이용자 모두가 어떻게 이용하는지가 중요하다.

마지막으로는 AI 시스템들이 발생시키는 이차적인 효과, 의도하지 않은 결과들을 고려해야 한다. 오랜 시간 연구한 주제는 이웃 시장(neighbor market)이나 구직 등에 미치는 영향이다. 동시에 고려해야 할 사항은 구글이 이러한 시스템을 세상에 어떻게 내놓을 것인지와 그로 인한 혜택(incentive)은 무엇인지에 대한 것이다. 연구모델 등을 제공할 때 어떻게 작동하고 영향을 미칠지 깊은 고려가 필요하다.

제임스: 구글이 이러한 문제에 대해서 어떻게 대응하고 있는지 설명해주실 수 있나요?

메리언: 내가 일하는 연구센터에서 하는 것이 바로 기술 실현을 책임감 있는 원칙과 결합하는 것이다. 구글이 2018년 발표한 백서도 이 내용을 담고 있다. 이용자와 위험방지(wardens of harm) 그리고 안전(safety)을 전통적인 기업의 가치(이익추구) 위에 두는 게 중요하다.

AI의 리더가 되려면 AI기술에 단순히 의존하는 것이 아닌 책임성 있는 AI기술의 첨단을 달려야 한다. 원칙들이 단순히 문서에 적힌 글자에 머무르면 안 된다. 책임성 있는 AI를 위해 대립적인(adversarial) 테스트를 지속하고, AI 시스템의 모든 측면을 측정하고 확인할 수 있는 정량화된 기준이 있어야 한다.

연구 영역에서 적응성과 민첩성을 제공하는 효율적인 파라미터 튜닝 세팅이 필요하다. 머신러닝 연구자만이 아니라 사회과학, 인권, 도덕 및 윤리 영역의 연구자들도 포용적으로 기술을 사용하도록 지원해 연구의 다양성도 넓혀야 한다.

데이터 수집부터 연구까지 모든 영역에서 구글 AI를 사용할 때 책임성 요소를 적용해야 한다. 이렇게 해서 다른 노력 없이도 AI 시스템을 자동으로 책임감 있게 사용할 수 있어야 한다.

제임스: 실용적 도구는 무엇이 있을까요?

메리언: 가장 대표적으로 구글의 언어 해석 도구(LIT, Language Interpretability tool)다. 연구자들에게 자신이 사용하는 모델이 어떻게 작동하고 있는지 시각적인 이해를 제공하는 도구이다. 첨단 연구에 있어 왜 이러한 결과가 나오게 됐는지, 변화된 입력을 넣으면 모델이 어떻게 작동할지 알려주는 것이다.

이는 연구자들에게 새로운 기술과 방법론을 이용해 모델을 향상시킬 수 있게 해준다. LIT는 오픈소스 플랫폼으로 제공돼 모두가 사용할 수 있다. 이러한 도구들이 매우 중요하다.

제임스: LaMDA와 같은 AI시스템을 어떻게 안전하게 이용할 수 있는가?

메리언: LaMDA는 매우 복잡한 모델이다. 데이터의 책임성을 검증하고 다시 이 데이터들을 학습시키고 검증하는 과정을 반복한다. 예를 들어 안전과 관련해 검증할 때, 유해성이 높은 대화 문장들을 사람이 레이블링 해 다시 데이터셋으로 모델에 적용하고 보완하는 식이다.

이러한 사람 기반의 탐지(Radar)에 다양성을 주는 것이 중요하다. 하지만 지금 업계 전반에서 마주한 문제 중 하나는 다양한 관점에서 발생하는 다양성들을 무시하고 일반적인 결과들을 뽑아내게 된다는 점이다.

다양성이 가져다주는 풍요로운 데이터의 가치를 긍정적인 방향으로 어떻게 보존하고 활용할 것인지 고민하는 것이 중요하다. LaMDA로부터 배운 가장 큰 교훈 중 하나는 분류기(classifier)엔 명확한 한계가 존재하는 점이다. 이것은 옳고 저것은 틀리다라는 이분법적인 접근으로 모델을 학습시키면 결국 기존 데이터가 갖는 다양성과 사람들이 실제로 하려던 행동들을 모델이 반영할 수 없게 된다.

결과적으로 진부하고 창의적이지 못한 결과들을 초래한다. 그래서 분류기에 대해 더 정교한 접근을 가져가 더 나은 결과를 만들어 내는 것이다. 예를 들어 내가 속한 문화를 포함해 여러 문화에서는 'Dope'라는 단어가 칭찬의 의미로 사용된다.

하지만 유해성 필터를 사용하면 이러한 표현은 그냥 사라지게 된다. 과도한 제지는 결국 다양한 관용적 표현을 활용할 수 없게 만든다. 사회에 존재하는 것들을 최대한 보존하면서 책임성도 구현할 수 있는 방안을 연구하고 있다.

제임스: 그로부터 배운 점들을 무엇이 있을까요?

메리언: 생성모델들이 결과를 꾸며내는 경향이 있다는 점이다. 때문에 우리는 AI모델의 결과가 실제 소스와 관련이 있을 수 있도록 적극적으로 연구, 필터 개발 등 노력을 기울이고 있다.

제임스: 책임성을 실제로 갖출 수 있는 방법을 찾은 연구에서 흥미로운 것은?

메리언: LaMDA와 같은 복잡한 모델을 비전문가도 사용할 수 있도록 하는 도구이다. 웹 기반 인터페이스와 유사한 형태로 AI 모델의 복잡성과 사용법을 모르더라도 이를 통해 AI 기반 서비스를 개발할 수 있게 해준다.

제임스: 제가 주목했던 것은 다양한 피부색의 인종들을 위한 'Monk Skin Tone Scale'이다. 기존의 'Patrick Skin Scale'을 개선해 모든 인류의 피부색을 반영할 수 있는 ML 피부색 스케일이 최근 구글 아이오(io)에서 오픈소스로 공개됐다.

이 모든 것은 개발자들 뿐만 아니라 조직, 정부기관, 이용자들까지 모두 함께 노력해야 하는 길이다. 구글은 규제들도 고려해야 하는데 어떻게 AI를 올바르게 사용할 수 있을지 고민하고 있다.

올바른 AI 사용은 첫째, 유익하고 효율적이며 보편적 이용이 가능한 AI를 개발해야 하는 것 둘째, 발생문제들을 어떻게 다루며 개발할 것인가에 대한 것이다. 올바른 AI 사용은 이 두 가지 측면을 모두 올바르게 수렴하는 것이라고 생각한다. 어떻게 생각하는가?

메리언: 동의한다. AI가 가져오는 혜택과 동시에 위험 요소도 크다. 그 영향이 매우 파괴적일 수 있기에 어떤 광범위한 혜택을 가져다주더라도 그로 인한 피해가 생긴다면 의미가 없다고 생각한다.

그리고 전문가 영역에서 벗어난 외부 커뮤니티들, 정책 입안자 등 여러 사람들과 협력하는 것이 중요하다. 올바른 AI를 위해 일종의 공동체(village)가 필요하다.

구글 입사 10개월째인 신경망 연구 권위자 제임스(James Manyika) 구글 기술과 사회 파트 VP(Senior VP of Google technology and society), 메리언(Marian Croak) 인간 중심 기술 AI 책임성 연구 센터 리더(leader of research center for responsible AI in human centered). 두 사람은 AI가 사회에 미치는 영향과 책임을 주제로 좌담을 가졌다.